| Accueil | Recherche | Publications | Enseignement |

|

[Thèmes] [Présentations] [Organisation de journées]

Contrôle de modèles génératifsCes travaux se sont déroulés dans le cadre de la thèse de Perla Doubinsky, doctorante financée par le programme ANR AHEAD en partenariat avec le CEA et co-encadrée par Hervé Le Borgne (chercheur au CEA) et Nicolas Audebert (enseignant-chercheur au CEDRIC). Les publications associées sont [DACB22], [DAC23] et [DAC24]. |

|

Apprentissage profond pour la compréhension de scènes visuellesCes travaux se sont déroulés dans le cadre de la thèse de Wafa Aissa, doctorante financée par une CIFRE avec la société XXii, et co-encadrée par Marin Ferecatu (enseignant-chercheur au CEDRIC). Les publications associées sont [AFC23] et [AFC23b]. |

|

Zero-Shot Learning, Generalized Zero-Shot LearningCes travaux se sont déroulés dans le cadre de la thèse de Yannick Le Cacheux, doctorant financé par le CEA et co-encadrée par Hervé Le Borgne (chercheur au CEA). Zero-Shot Learning (ZSL) concerne la reconnaissance de classes dont aucun exemple n'a été vu lors de l'apprentissage, grâce à l'utilisation de prototypes sémantiques de classes. Nos premiers travaux publiés sur ce sujet, [CBC19], montrent qu'une approche simple de calibration et de régularisation permet d'améliorer de façon significative les résultats des méthodes existantes sur le problème généralisé (GZSL) dans lequel les classes candidates lors de la reconnaissance ne se limitent pas aux classes non vues. Cette approche met en évidence aussi qu'un simple modèle linéaire parcimonieux peut égaler et parfois dépasser les résultats de l'état de l'art. Dans [CBC19b] nous identifions trois hypothèses implicites faites par les méthodes de l'état de l'art et proposons des solutions adaptées, qui permettent d'améliorer les performances par rapport aux méthodes existantes, y compris aux approches génératives. Enfin, dans [CBC20a] nous examinons l'extraction de prototypes sémantiques à partir de phrases descriptives. Un état de l'art est présenté dans [CBC21] |

|

Apprentissage à partir de données en fluxDes travaux récents dans le cadre de la thèse de Andrey Besedin, doctorant financé par le CEA et co-encadrée par Marin Ferecatu (CEDRIC) et par Pierre Blanchart (chercheur au CEA) s'intéressent à l'apprentissage à partir de données en flux. Dans un flux la distribution des données est non stationnaire, de nouvelles classes peuvent apparaître alors que certaines anciennes classes peuvent être absentes pendant un certain temps et ensuite revenir, etc. De plus, il n'est pas envisageable de stocker la totalité des données étiquetées du flux pour refaire régulièrement l'apprentissage avec la totalité des données étiquetées. Nous avons proposé des solutions (voir [BBC17, BBC18, BBCF20]) basées principalement sur les generative adversarial networks (GAN) et les auto-encodeurs pour faire face aux difficultés posées par les données en flux, sans exiger le stockage des données historiques. |

|

|

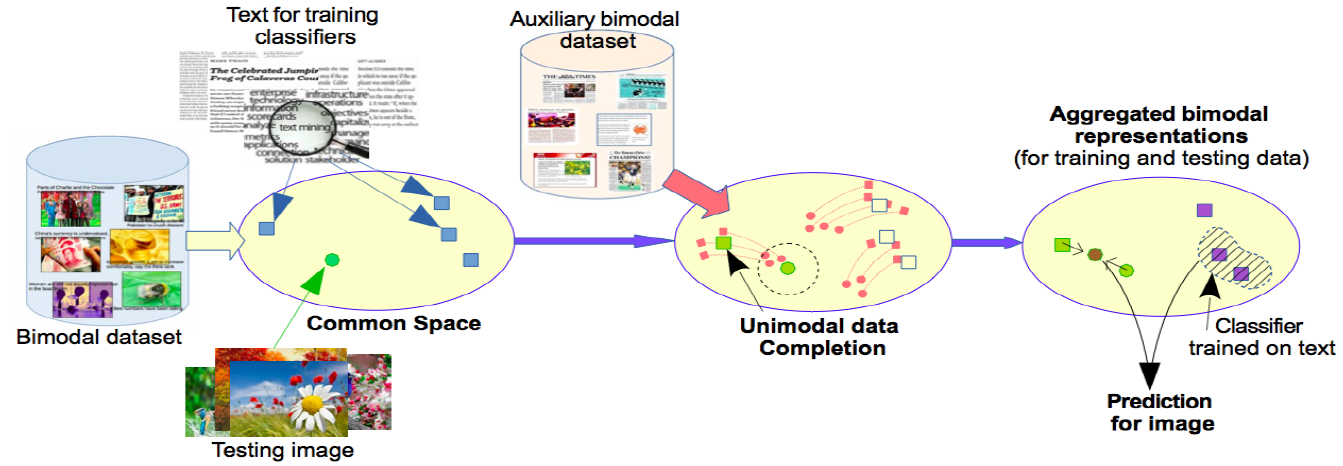

Recherche trans-modale, classification trans-modaleCes travaux dans le cadre de la thèse de Thi Quynh Nhi Tran, doctorante au CEA co-encadrée par Hervé Le Borgne, ont concerné la recherche trans-modale par le contenu : recherche d'images à partir de textes (text illustration) recherche de textes à partir d'images. Les premiers résultats publiés visaient la combinaison de la recherche dans un espace latent (obtenu par analyse canonique des correspondances à noyaux) et des indices rares (donc mal représentés sur l'espace latent) mais très pertinent, correspondant par exemple à des entités nommées, voir [TBC15]. Dans [TBC16] nous avons proposé une méthode permettant de compléter une représentation unimodale pour obtenir une représentation bimodale, avec un impact très significatif sur les performances de la recherche trans-modale. Dans [TBC16b] nous nous sommes intéressés, avec de bons résultats, à un problème nouveau que nous avons appelé "classification trans-modale" et qui consiste à apprendre des classifieurs sur une modalité (par ex. le texte) et à les appliquer ensuite sur une autre modalité (par ex. l'image). Thi Quynh Nhi Tran a soutenu sa thèse le 3 mai 2017 et travaille actuellement dans la société Invivoo. Ces travaux ont motivé le démarrage de travaux sur Zero-Shot Learning, voir plus haut. |

|

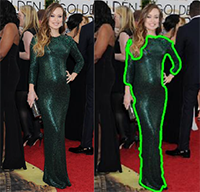

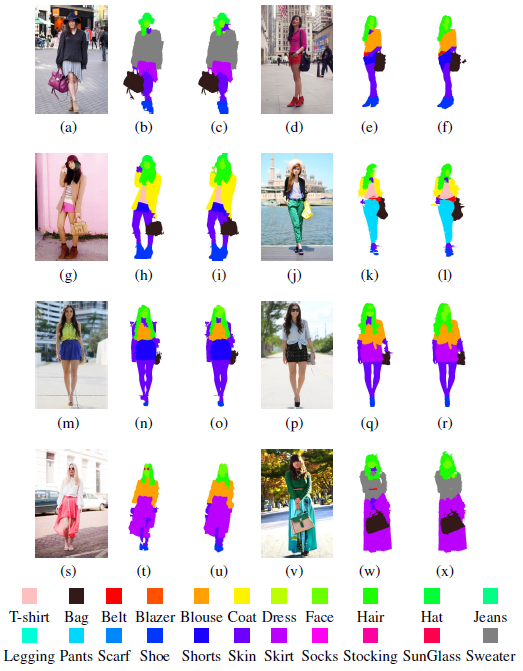

Extraction de vêtements à partir d'images de modeCes travaux se sont déroulés dans le cadre de la thèse de Lixuan Yang, co-encadrée par Marin Ferecatu, en CIFRE avec la société Check Lab. L'objectif était d'extraire des vêtements à partir d'images de mode issues du web, afin de pouvoir décrire de façon précise ces images et faire des recherches par similarité. Les premiers résultats, concernant des robes longues, ont été publiés dans [YRFC16]. La méthode a connu des évolutions significatives permettant de traiter avec de bons résultats différentes catégories de vêtements, voir [YRFC16b, YRFC17]. Lixuan Yang a soutenu sa thèse le 10 juillet 2017. Ces travaux devraient se poursuivre, sous une forme différente, dans une thèse CIFRE dont l'objectif principal est la compréhension de scènes visuelles. |

|

Détection et localisation d'actions dans de grandes bases vidéo (2013-2015)Dans le cadre du projet ANR Blanc International Mex-Culture nous avons travaillé avec Andrei Stoian, Marin Ferecatu et Jenny Benois-Pineau sur la localisation et la recherche (y compris interactive) d'actions dans les vidéos, voir [SFBC15b] et [SFBC15a]. Nous avons proposé un système de détection à deux étages : un premier qui filtre une majeure partie de la vidé à partir de représentations compactes, un second qui classe les résultats par une 1-class SVM à noyau global alignment [SFBC15b] ; une technique de sélection de variables sur les séquences permet à ce noyau d'être efficace. Nous avons également proposé une méthode approximative qui retourne les occurrences d'une action sans avoir à examiner exhaustivement le contenu de la base [SFBC15a]. Une base d'évaluation de la détection et localisation d'actions, appelée MEXaction2, a été rendue publique sur le site du projet. Andrei Stoian a soutenu sa thèse le 15 janvier 2016 et travaille actuellement dans la société Thales. |

|

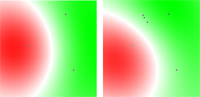

Recherche interactive d'images avec retour de pertinence (2003-2010)Les premiers travaux dans ce thème, avec Marin Ferecatu (doctorant INRIA) et Nozha Boujemaa (DR INRIA) dans le projet IMEDIA de l'INRIA Rocquencourt, ont porté sur l'optimisation de l'apprentissage actif [FCB04a], [FCB04b] et sur la recherche hybride avec des descriptions visuelles et conceptuelles des images [FBC08a], [FBC08b]. En collaboration avec Jean-Philippe Tarel (chercheur au LCPC) nous avons exploré l'espace des comportements possibles de l'utilisateur lors d'une session de recherche avec retour de pertinence et examiné l'impact de ce comportement sur l'évaluation des mécanismes de recherche [CTF08]. Les travaux ultérieurs, démarrés à l'INRIA et poursuivis dans Vertigo avec Daniel Estevez (ingénieur CNAM), Vincent Oria (Pr. New Jersey Institute of Technology) et Jean-Philippe Tarel, ont concerné essentiellement le passage à l'échelle de la recherche avec retour de pertinence. Nous avons proposé une extension du M-tree construit dans l'espace d'arrivée d'un noyau à des requêtes par hyperplans, qui permet d'effectuer des recherches interactives dans des bases d'env. 110000 images [CEOT09]. Les travaux avec Wajih Ouertani (doctorant INRA) et Nozha Boujemaa, dans le cadre du projet Pl@ntNet, concernaient la recherche interactive par ensembles de descriptions locales des images [OCB10], [OBC10]. |

|

Classification automatique (2005-2010)Le thème de la classification semi-supervisée active a été abordé avec Nizar Grira (doctorant INRIA) et Nozha Boujemaa (DR INRIA) dans le projet IMEDIA de l'INRIA Rocquencourt. Le premier objectif était de permettre la prise en compte, lors d'une classification automatique, des avis d'un expert du domaine d'application, sous la forme de contraintes binaires must link et cannot link. Nous avons proposé une extension de l'agglomération compétitive, basée sur une fonction de coût intégrant un terme spécifique pour les contraintes [GCB06]. Afin d'optimiser l'exploitation des contraintes fournies par l'utilisateur en interaction avec le système, nous avons développé une nouvelle version, active, de cet algorithme [GCB08], appliquée aux données Arabidopsis du projet BIOTIM financé par l'ANR. Ces travaux ont motivé en partie la création de la e-team Active and Semi-Supervised Learning du Réseau d'Excellence européen MUSCLE. Souvent, dans un ensemble de données sont présents des regroupements sur plusieurs critères complémentaires: le regroupement suivant un critère fournit peu d'information sur le regroupement selon un autre critère. Lorsque ces critères ne sont pas connus a priori, il est nécessaire de les déterminer à partir des données. Dans [PC10] nous avons proposé une nouvelle méthode, inspirée de la tree-component analysis, pour trouver à la fois les critères complémentaires et les regroupements suivant chaque critère. |

|

Détection de copies vidéo par le contenu et fouille vidéo (2006-2010)La détection de copies vidéo par le contenu a comme principales applications la protection des droits et la structuration automatique de grandes bases vidéo. Le passage à l'échelle de la détection de copies est un des principaux problèmes à résoudre pour traiter des situations réélles. Les recherches menées dans ce domaine avec Sébastien Poullot (doctorant CIFRE Vertigo-INA) et Olivier Buisson (chercheur INA), en relation avec le projet RIAM Sigmund, ont abordé aussi bien la surveillance de flux que la fouille de grandes bases vidéo. Pour le premier sujet nous avons mis au point une solution d'indexation basée sur une modélisation des données et des transformations attendues, permettant de surveiller, en temps réél différé avec 1 ordinateur normal, un flux vidéo par rapport à une base de contenus originaux de 280000 heures ([PBC09], [PBC07]). Bien que cette méthode puisse être utilisée également pour la fouille par détection de copies, nous avons proposé une approche alternative qui assure un bien meilleur passage à l'échelle dans ce nouveau contexte. Nous avons développé des représentations plus compactes (descripteur Glocal) des images-clés et une solution d'indexation qui combine des idées issues du hachage et des listes inversées pour traiter de façon efficace l'auto-jointure par similarité réalisée sur la base de signatures. Grâce à ces propositions, une base de 10000 heures de vidéo peut être fouillée en env. 3 jours [PCB08] et les env. 70 heures de vidéo correspondant aux réponses à une requête par mots clés sur un site Web2.0 en env. 45 secondes [PCB08c]. Par ailleurs, une implémentation parallèle efficace de la méthode peut être réalisée facilement [PCB08b]. Ces résultats ont été nettement améliorés (en termes de précision et de rappel, ainsi que de rapidité de la recherche), dans le cadre d'une collaboration avec Shin'ichi Satoh, du National Institute of Informatics (Tokyo), par utilisation de groupes localisés de local features dans la génération des signatures Glocal et d'une information simple de configuration géométrique [PCSC09]. De nouvelles idées identifiées pour la détection de copies vidéo (résumés temporels locaux, LSH multi-niveaux) ont été appliquées d'abord à la détection de multi-variant audio tracks (ou cover songs), en collaboration avec Vincent Oria et Yi Yu du New Jersey Institute of Technology [YCOC09], [YCOD10]. |

|

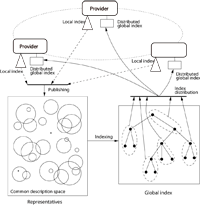

Recherche par le contenu en environnement distribué hétérogène (2007-2009)Les travaux sur ce thème, avec François Boisson (doctorant dans Vertigo) et Dan Vodislav (Pr. Univ. Cergy-Pontoise), étaient inscrits dans le cadre du projet DISCO (Distributed Indexing and Search by COntent) financé par l'ANR. Nous considérons que la recherche de contenu multimédia par le grand public doit faire face à au moins deux évolutions majeures dans l'avenir proche : la prise en compte de critères basés sur le contenu multimédia et une forte croissance du volume de contenu numérisé disponible au niveau de chaque fournisseur. Dans ce contexte, la plupart des fournisseurs doivent disposer d'un index local pour chercher de façon efficace dans leurs propres bases. Une diversité significative est attendue pour les types d'index locaux employés. Par ailleurs, chaque fournisseur souhaite avoir un contrôle complet de son index local qu'il considère comme un asset ; ces index locaux ne peuvent donc pas être entièrement diffusés. Afin de pouvoir répondre aux exigences d'une recherche uniforme et efficace dans ce contexte, nous avons proposé une approche basée sur sur la publication par chaque fournisseur, dans un format consensuel, de "représentants" associés aux parties de l'index local où le fournisseur souhaite rendre son contenu "visible" par d'autres. Les représentants publiés par tous les fournisseurs servent à construire un index global distribué qui est employé pour répondre à des recherches par similarité (voir [BCV08], [BCV08b]). |

Autres thèmes de recherche antérieurs : analyse de documents (2000-2002), réseaux de neurones et séries chronologiques (1996-2002), représentations structurées dans les réseaux de neurones (1991-1995), réseaux systoliques (1989-1990).

20/11/2014 : Présentation invitée dans le cadre du workshop "Similarity, K-NN, Dimensionality, Multimedia Databases" (20-21 novembre 2014, Rennes, France).

1/11/2014 : Conférence invitée "Multimedia information retrieval: beyond ranking" à "International Workshop on Computational Intelligence for Multimedia Understanding" (IWCIM, Paris, 2014).

2/07/2010 : Passage à l'échelle de la recherche et de la fouille de contenus multimédia (voir la vidéo), conférence invitée lors des Assises du GDR Information - Interaction - Intelligence (I3)

1/04/2009 : Scalable Content-Based Video Copy Detection, Séminaire au New Jersey Institute of Technology

12/01/2012 : Bilan TRECVID et problèmes industriels

3/11/2010 : Passage à l'échelle de la recherche et de la fouille de contenus multimédia (env. 35 participants ; compte-rendu avec accès aux présentations)

9/06/2009 : Passage à l'échelle dans la recherche d'information multimédia (env. 40 participants ; compte-rendu avec accès aux présentations)

| Vertigo | CEDRIC | CNAM | © Michel Crucianu | A propos de ce site | 9 octobre 2024 |